Il Vero Pericolo dell'Intelligenza Artificale

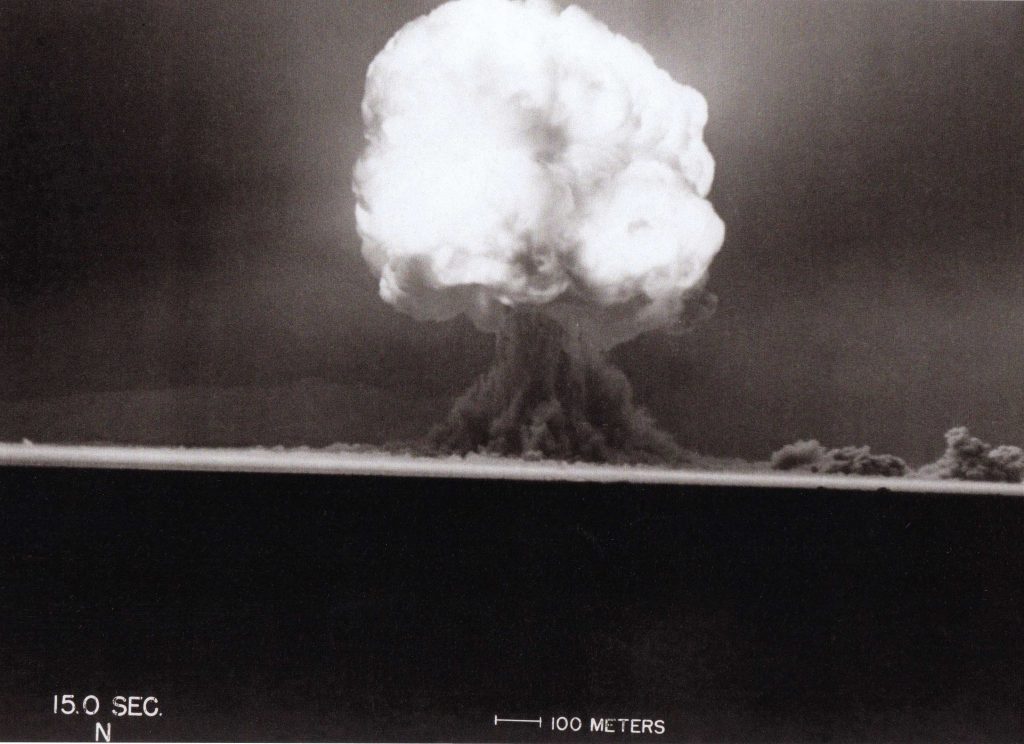

La Trinity test, 15 secondi dopo detonazione

Recentemente, sto rifletendo molto sul Manhattan Project (Probabilmente perchè ho appena guardato il film più recente di Christopher Nolan, ‘Oppenhiemer’) e la inevitabilità della bomba atomica. Cioé, che la costruzione di tale bomba fosse destinata a verificarsi, indipendentemente dall’esito della seconda guerra mondiale. Se la fisica la rendeva possibile, qualcuno l’avrebbe costruita. Non c’è dubbio. Penso che la ragione per cui questa realtà mi lascia un po’ pensieroso sia per i paralleli che si possono trovare tra la fisica e le scienze dell’intelligenza (IA, neuroscienza, psicologia, etc). I Software che inducano dipendenza per rubarti i dati privati già esistono. Questi dati possono essere sfruttati in un miriade di modi usando l’IA per approfittare finanziariamente, politicamentente, etc. Abbiamo già tutti gli atomi di uranio di cui abbiamo bisogno, dobbiamo solo scinderli.

La motivazione che ha spinto gli Americani a costruire la bomba atomica era la semplice realtà che il paese che l’aveva prima avrebbe approfitato immensamente. Ma il motivo per cui ci sono riusciti prima, invece di qualcun altro, è che loro avevano il potere d’estrarre l’uranio e i soldi da buttare a gli scienziati. Non c’entrava la nozione che in qualche modo l’avrebbero fatto in un modo migliore. Analogamente, le imprese con tutti i nostri dati personali a loro disposizione saranno quelli che creeranno l’IA del futuro; questo regime, come abbiamo visto con gli Americani e la loro bomba, creerà un intelligenza che avvantaggerà loro stessi ¿E cos’è che aumenta i profitti di Meta (Facebook), TikTok, Apple, Microsoft, etc. oltre di l’induzione di dipendenza, manipolazione, e la diffusione di disinformazione?

Nell’epoca dell’informazione la nostra prossima bomba non sarà esplosivo. Di fatti, non si potrà nè sentire e nè vedere. Pubblicità personalizzata da un IA addestrata su i post che ti fanno scattare l’Impulsività, così bravo a nascondersi che si mimetizza con tutti i post precedenti. Phishing accounts sui social addestrata a manipolare e rubare alle vittime. Predando su quelli che tengono a fare gli amici online. Una nazione invade un piccolo paese. Poi, riempiono l’internet con profili fantoccio affermando che la nazione sta solo recuperando la sua terra legittima, citando documenti che pure sono stati fabbricati con IA. Non deve neanche convincere il popolo per essere effettivo, deve solo impiantare un piccolo dubbio.

L’intelligenza artificiale, come qualsiasi alto strumento, non può fare nulla da solo. Se una macchina rotoli giù da una collina, qualcuno l’avrà lasciato senza freno tirato. Il pericolo più grave dell’IA non e l’IA in se stesso. IA sarà la tecnologia più rivoluzionaria delle nostre vite. L’unico pericolo che l’IA può imporre su di noi dipende da quelli che potranno utilizzarlo.

Come si può Regolare la Costruzione di IA?

Ovviamente nessuna legge potrà effetivamente rallentare la ricerca di un’arma così potente. Quello che si può fare è informare il pubblico così che non possono costruire niente di devastante alla luce del sole. scombussolando qualsiasi cosa Tiktok o Meta stanno provando a fare ora.

¿Cosa dobbiamo fare per assicurare la sicurezza nell’ambito dell’IA? Io, ovviamente, non ho risposta a questa domanda. Serebbe come se chiedessi a qualcuno che non c’entrava con il Manhattan Project come regolare la fisica nucleare in modo che nessuno costruisse una bomba. Posso solo condivedere delle idee che mi sono vdellaenute mentre studiavo questo argomento.

Rilevato al utente

Se l’IA sarà usata nel software eticamente, l’uso deve essere rilevato al utente e si dovrebbe dare la capacità di dissativarlo in qualche modo. Mentre questo è supratutto importante per i feed dei social, io credo che dovrebbe estendersi a tutti gli utilizzi di IA. Se il mio input è visibile ad un’intelligenza che può imparare, mi deve essere comunicato in un modo chiarissimo come viene usato.

Restrizione di Sviluppo

L’IA non potrà essere sviluppato con le stesse tecniche usate nello sviluppo del software. IA generica può diventare pericolosa molto velocemente, sopratutto se è calibrata per un altra attivitá. Per non parlare del fatto che se i valori morali dell’intelligenza sono impostati da una megacorporation, saranno pieni di pregiuizi da cima a fondo; basta guardare ChatGBT, Bing, Bard, etc. Altrimenti, mi piacerebbe vedere più soùtware per addestrare i modelli (allevierebbe anche la dipendenza da aziende come OpenAI di cui tanti informatici soffrano).

Naturalmente, niente di questo potrà essere effetivo senza educazione. Mentre siamo sulla cresta dell’onda di un profondo cambiamento tecnologico e sociale, l’innovazione avverà qualsiasi cosa accada. La parte più importante è l’educazione sull’argomento di utilizzo e sicurezza dell’IA. La gente deve capire ciò che è, e non è, sbagliato e pericoloso, se no abbiamo un altro problema da risolvere come i social.